Hace 50 años tres astronautas comenzaron su viaje al satélite con un computador de vuelo que palidecería ante cualquier móvil actual. Sin embargo, su diseño fue un hito y un éxito absoluto

«Estamos bien», informó un lacónico Neil Armstrong, a 25 segundos del despegue de la misión Apolo 11, hoy hace 50 años. Instantes después, a las 09.32 del 16 de julio de 1969, el cohete Saturno V cobró vida en la plataforma A del complejo de lanzamiento 39 del Centro Espacial Kennedy. En tierra, un millón de personas, entre los que había 2.700 reporteros, periodistas y personalidades, contenían el aliento, soportando el calor y equipados con gafas se sol, telescopios y prismáticos. Los cinco motores F-1 tardaron nueve segundos en llegar a la máxima potencia, alcanzando un consumo de 13.000 litros de hidrógeno y oxígeno líquidos por segundo. Tenían capacidad para producir 3,4 millones de kilogramos de empuje.

En ese momento, los pernos explosivos saltaron y el Saturno V, con sus 111 metros de altura y 3.000 toneladas, comenzó a ascender pesadamente, mientras cinco brazos metálicos de 20 toneladas se abrían como una flor en la torre de lanzamiento. El trueno tardó 15 segundos en llegar hasta los espectadores, causando un clamor comparable a «un ladrido ensordecedor de mil ametralladoras que disparan al mismo tiempo», según escribió Norman Mailer. «¡Aaaah!» gritaba la muchedumbre, entre vítores que bien podrían haber sido lamentos de angustia.

Enseguida, la primera fase del cohete consumió sus 2.008.994 kg de combustible. 12 minutos después de despegue, la misión Apolo 11 estaba en órbita. A sus mandos estaba el comandante Neil Armstrong, Buzz Aldrin, piloto del módulo lunar y Michael Collins, piloto del módulo de mando. No se llevaban muy bien, pero demostraron ser profesionales extraordinarios, en parte gracias al entrenamiento más intensivo de toda su carrera.

El cuarto tripulante

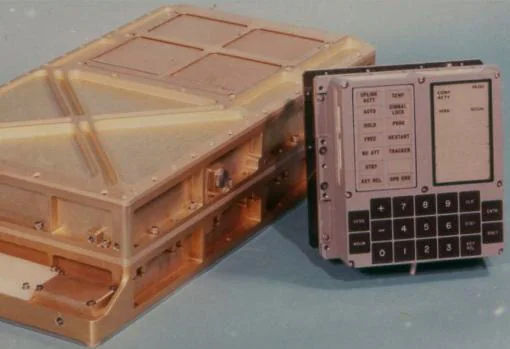

A su lado viajaba un cuarto tripulante. Dentro de la maraña de 24 kilómetros de cables que componían la nave, había un ordenador de a bordo de nombre AGC (« Apollo Guidance Computer»), cuyas funciones eran cruciales para el éxito de la misión: debía controlar los sistemas de estabilización, los encendidos del motor, calcular la posición de la nave y dirigir todas las fases del vuelo. Fue un pináculo de la ingeniería humana y uno de los puntos más complejos de la misión. Curiosamente, su potencia palidecería ante cualquier smartphone actual: era una dos mil veces más lento (su velocidad era de 2.048 MHz) y su memoria era mínima: tenía 72 kilobytes para almacenar programas y otros cuatro para almacenar datos, cuando cualquier móvil de hoy en día tiene varios gigabytes (del orden de 100 o 1.000 veces más).

La idea era que el ordenador hiciera todas aquellas tareas que no pudiera hacer un humano. Esto no le gustó nada a los astronautas, pilotos acostumbrados a controlar su avión con palancas, y nada partidarios de usar un teclado en vuelo. Pero, finalmente, el dispositivo cumplió con gran éxito su trabajo: fue el que hizo las operaciones vectoriales más complejas para calcular las rutas y el que mantuvo la nave girando en todo momento en el espacio para mantener uniforme la temperatura de su superficie. Su catálogo contenía las coordenadas de cuarenta estrellas para alinear la nave y facilitar la navegación, y los astronautas pudieron darle instrucciones en tiempo real para responder rápido a las necesidades.

El AGC recibía datos desde multitud de sensores, como la unidad inercial, el sextante o el telescopio de navegación. Y los astronautas introducían instrucciones por medio de un sencillo teclado. Se empleó un sistema de «verbo» y «nombre»: el primero correspondía a la acción que realizar y el segundo al dato que había que utilizar. Tanto unos como otros estaban codificados según un índice numérico memorizado por los pilotos. Así, por ejemplo, los programas de la serie 60 eran aquellos que dirigían la reentrada en la atmósfera, la apertura del paracaídas y el amerizaje.

Sin embargo, lo cierto es que la mayor parte de las operaciones fue ejecutada por el potente centro de cálculo de Houston. Este reunía una capacidad de computación colosal para la época, con cinco potentes ordenadores IBM 360/750, con un megabyte de memoria central, instalados ex profeso para dar soporte a la misión. A su alrededor había 42 unidades de cinta, 25 impresoras y dos docenas de unidades de memoria auxiliar.

Un prodigio del momento

El AGC fue un prodigio de la miniaturización de la época. Pesaba unos 35 kilogramos y abultaba lo mismo que un maletín, cuando los ordenadores del momento ocupaban habitaciones enteras. Su consumo de energía era comparable al de una bombilla de potencia media. Además, su diseño era casi totalmente infalible.

Además, y a pesar de su escasa potencia, el AGC se convirtió en un hito. Fue el primero en el que se usaron circuitos integrados o microchips, lo que fue crucial para sustituir los ordenadores basados en tubos de vacío. Uno de los creadores de estos dispositivos, fue cofundador de Intel.

El computador de vuelo del programa Apolo también fue el precursor de los sistemas «fly-by-wire», que en aviones se emplean para pilotar por medio de mandos electrónicos. Constaba de un sencillo teclado numérico, unos pocos pulsadores, indicadores luminiscentes de siete segmentos y pilotos luminosos, que en conjunto recibieron el nombre de DSKY (siglas de «display and keyboard»).

Además, Hal Lanning, uno de los líderes del proyecto, introdujo el uso de «interrupciones», instrucciones que detenían la ejecución de los programas para satisfacer peticiones importantes. Por otra parte, el AGC estaba diseñado para no fallar jamás. Sus programas establecían «puntos de retorno» para que, si la máquina se quedaba bloqueada, se volviera a iniciar la secuencia antes del fallo. Además, a diferencia de muchos móviles, el AGC podía recuperarse de un error de forma instantánea, lo que era crucial para el bienestar de la cápsula y su tripulación, tal como se pudo comprobar en la misión Apolo 11.

Una memoria realmente física

La memoria del ordenador estaba formada por núcleos de ferrita, una primitiva tecnología basada en la magnetización de minúsculos anillos metálicos agrupados en matrices. Para cada misión, el ordenador era programado a mano por un equipo de «costureras», que enhebraban las ferritas en una malla de conductores eléctricos: la presencia de un núcleo de ferrita en un cruce de hilos equivalía a un uno binario; su ausencia, a un cero.

Se puede decir que este computador tenía un sistema operativo muy rudimentario. Estaba formado por tres sistemas: el Basic, un lenguaje de programación, el Interpreter, con las rutinas para los cálculos complejos, y el Executive, encargado de llamar a unos programas u otros en la secuencia correcta.

La misión Apolo 11 dependió de dos ordenadores AGC: uno para el módulo de mando y otro para el módulo lunar; ambos eran idénticos pero tenían distinto software. Por ejemplo, el primero contenía instrucciones para el regreso a la Tierra (sus códigos se llamaban Colossus), y el segundo para el alunizaje (sus líneas de código se llamaban Luminaire). Además, había un ordenador de seguridad, llamado sistema de guía de cancelación («Abort Guidance System».

Una tarea titánica

Los AGC fueron desarrollados por el prestigioso Instituto Tecnológico de Massachusetts (MIT), aprovechando su experiencia en sistemas de guiado de misiles balísticos lanzados desde submarinos, y construido por la compañía Raytheon. Su diseño fue responsabilidad del equipo de Charles Stark Draper, y el software fue desarrollado en gran parte por Hal Lanning y la ingeniera Margaret Hamilton.

El listado de todo el software del AGC empleado en el programa Apolo ocupaba en papel una pila tan alta como una persona, y en total requirió el trabajo equivalente a 1.400 años de una persona.

El desarrollo del AGC y el programa Apolo consumió un millón de chips, equivalentes al 60% de la producción total de la industria estadounidense de la época, básicamente orientada al guiado de los misiles balísticos apuntados hacia la Unión Soviética y a otras aplicaciones militares. En total, se construyeron 42 AGC, que alcanzaron un precio de 200.000 dólares de la época (equivalente a un millón y medio actuales). En algunos momentos hubo hasta 400 ingenieros trabajando en el desarrollo de sus programas.

Según explicó para AFP Frank O´Brien, historiador y autor de «The Apollo Guidance Computer: Architecture and Operation», la NASA «tenía unos requerimientos increíbles, absolutamente inimaginables» para la fiabilidad de estos chips. Por tanto, el colosal programa Apolo obligó a los fabricantes a mejorar sus diseños y a crear dispositivos más duraderos.

Errores en el ordenador antes del alunizaje

Parece que la estrategia dio sus frutos. El 20 de julio, momentos antes de que el módulo lunar se posase en el satélite, las pulsaciones de Neil Armstrong se dispararon: «¡Alarma de programa!», gritó el comandante. Aldrin confirmó que se trataba de la alarma 1202. En el control de la misión se miraron perplejos. ¿Qué demonios era la alarma 1202?

Se decidió proseguir con las maniobras para posar el módulo Águila en el satélite. Cuando habían descendido hasta los 1.524 metros, volvió a sonar la alarma. Esta vez se trataba del error 1201. «Seguimos con el plan», dijo Steve Bales, el controlador. Él parecía ser el único que comprendía lo que ocurría, en aquellos instantes críticos. Medio mundo contenía el aliento.

El problema es que el AGC estaba sobrecargado por recibir demasiada información. Según se averiguó después, los astronautas dejaron encendido el radar de acoplamiento, sobrecargando a la pequeña máquina mientras trabajaba en el alunizaje. Como resultado, el ordenador abandonó algunas operaciones y comenzó de cero de nuevo, poniendo fin al problema.

«La forma como el ordenador lidió con la sobrecarga fue un auténtico hito», explicó en AFP Paul Ceruzzi, experto de la Institución Smithsonian.

A segundos del desastre

La tensa calma duró poco. Bajo el módulo lunar apareció un dramático panorama. El ordenador les dirigía hacia un grupo de rocas, del tamaño de coches. Enseguida, Armstrong tomó los controles y desplazó el Águila horizontalmente, cuando apenas les quedaban unos minutos de combustible. Todos sabían que si no lo lograba, deberían abortar el aterrizaje y volver al módulo de mando, o perecer en la Luna.

«¿Cómo vamos de combustible?», preguntó Armstrong. «Ocho por ciento», respondió un escueto Aldrin. «220 pies, 30 hacia delante, descendemos de maravilla», relató el comandante. En el control de la misión todos mantuvieron el silencio. «Sesenta pies, descendemos dos y medio, dos hacia delante».

Entonces, Charlie Duke, comunicador de la cápsula dijo: «Sesenta segundos». Era el tiempo que les quedaba de combustible antes de tener que abortar la misión. Armstrong examinaba la superficie lunar a la desesperada, tratando de encontrar el lugar idóneo para el aterrizaje. El motor del módulo ya levantaba volutas de polvo lunar. «Treinta segundos», dijo Duke, lacónicamente.

Antes de que cundiera el pánico, Aldrin gritó: «¡Luz de contacto!». Eso significaba que el módulo se había posado en la superficie. Armstrong paró el motor y con un ruido sordo, la nave se detuvo. El Apolo 11 había logrado lo imposible: el hombre había llegado a la Luna.