Artículo publicado por Signe Brewster el 20 de enero de 2016 en Symmetry Magazine

La misteriosa partícula podría tener la clave de por qué la materia prevaleció sobre la antimateria en los inicios del universo.

Casi todas las partículas tienen un

homólogo de antimateria: una partícula con la misma masa pero carga

opuesta, entre otras características.

Esto parece aplicarse a los neutrinos,

minúsculas partículas que nos atraviesan constantemente. A partir de las

partículas liberadas cuando un neutrino interactúa con la materia, los

científicos pueden discernir si han captado un neutrino contra un

antineutrino.

Pero ciertas características de los

neutrinos y los antineutrinos hacen que los científicos se pregunten:

¿Son los mismos? ¿Son los neutrinos sus propias antipartículas?

Esto no es una novedad. Los gluones e

incluso los bosones de Higgs se cree que son sus propias antipartículas.

Pero si los científicos descubren que los neutrinos son sus

antipartículas, podría darnos una pista sobre por qué tienen esa masa

tan minúscula — y si desempeñaron un papel en un universo predominado

por la materia.

Dirac contra Majorana

La idea de antipartícula procede de

1928, cuando el físico británico Paul Dirac desarrolló lo que se ha

llegado a conocer como ecuación de Dirac. Su trabajo buscaba explicar

qué sucedía cuando los electrones se movían a una velocidad cercana a la

de la luz. Pero sus cálculos dieron como resultado un extraño

requisito: que los electrones, a veces, tenían energía negativa.

“Cuando Dirac escribió su ecuación es

cuando supo que las antipartículas existían”, señala André de Gouvêa,

físico teórico y profesor en la Universidad Northwestern. “Las

antipartículas son una consecuencia de su ecuación”.

El físico Carl Anderson descubrió el

compañero de antimateria del electrón que Dirac previó en 1932. Lo llamó

positrón – una partícula como el electrón, pero con una carga positiva.

Dirac predijo que, además de tener

cargas opuestas, los homólogos de antimateria deberían tener otra

característica opuesta, conocida como quiralidad, que representa una de

las propiedades cuánticas inherentes que tiene una partícula. Cada

partícula puede tener una quiralidad dextrógira o levógira.

La ecuación de Dirac permitió que

neutrinos y antinetrinos fuesen partículas distintas y, como resultado,

eran posibles cuatro tipos de neutrinos: neutrinos con quiralidad

levógira y dextrógira, y antineutrinos también con ambas quiralidades.

Pero si los neutrinos no tenían masa,

como pensaban los científicos en aquella época, sólo se requeriría la

existencia de neutrinos levógiros y antineutrinos dextrógiros.

En 1937, el físico italiano Ettore

Majorana debutó con otra teoría: neutrinos y antineutrinos eran en

realidad lo mismo. La ecuación de Majorana describía que los neutrinos,

si después de todo tenían masa, podrían convertirse en antineutrinos, y

viceversa.

El desequilibrio materia-antimateria

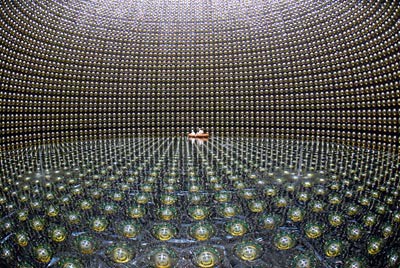

Si la masa del neutrino era cero o no,

siguió siendo un misterio hasta 1998, cuando los experimentos

Super-Kamiokande y SNO hallaron que realmente tenían una masa muy

pequeña — un logro reconocido con el Premio Nobel de Física de 2015.

Desde entonces, han surgido experimentos en Asia, Europa y Norteamérica

buscando pistas de que el neutrino es su propia antipartícula.

La clave para encontrar esta prueba es

algo llamado conservación del número leptónico. Los científicos

consideran una ley fundamental de la naturaleza que el número leptónico

se conserve, lo que significa que el número de leptones y antileptones

implicados en una interacción debería ser igual antes y después de que

tenga lugar dicha interacción.

Los científicos creen que justo después

del Big Bang, el universo debería haber contenido las mismas cantidades

de materia que de antimateria. Los dos tipos de partículas deberían

haber interactuado, cancelándose gradualmente entre sí hasta que no

quedase más que energía. De algún modo, no es así como sucedió.

Descubrir que el número leptónico no se

conserva abriría una puerta que permitiría el actual desequilibrio entre

materia y antimateria. Y las interacciones entre neutrinos podrían ser

el lugar donde encontrar dicha puerta.

Desintegración doble beta sin neutrinos

Los científicos están buscando la

violación del número leptónico en un proceso conocido como

desintegración doble beta, dice el teórico de SLAC Alexander Friedland,

que está especializado en el estudio de los neutrinos.

En su forma más común, la desintegración

doble beta es un proceso en el cual un núcleo se desintegra en un

núcleo distinto y emite dos electrones y dos antineutrinos. Esto

equilibra la materia y antimateria leptónica antes y después del proceso

de desintegración, por lo que se conserva el número leptónico.

Si los neutrinos son sus propias

antipartículas, es posible que los antineutrinos emitidos durante la

desintegración doble beta pudiesen aniquilarse entre sí y desaparecer,

violando la conservación del número leptónico. Esto es lo que se conoce

como desintegración doble beta sin neutrinos.

Dicho proceso sería favorable a la materia sobre la antimateria, creando un desequilibrio.

“Teóricamente, provocarían una profunda

revolución en nuestra comprensión de dónde logran su masa las

partículas”, señala Friedland. “También nos diría que hay una nueva

física a unas escalas de energía altísimas — que hay algo nuevo más allá

del Modelo Estándar que conocemos y queremos”.

Es posible que neutrinos y antineutrinos

sean diferentes, y que haya dos estados para los neutrinos y otros dos

para los antineutrinos, como se requiere en la ecuación de Dirac. Los

dos estados que faltan podrían ser tan esquivos como para que los

físicos aún no los hayan observado.

Pero observar las pruebas de una

desintegración doble beta sin neutrinos sería una señal de que Majorana

tuvo la idea correcta — neutrinos y antineutrinos son lo mismo.

“Son experimentos muy complejos”, señala de Gouvêa. “Son similares a

los experimentos de materia oscura, en el sentido de que tienen que

realizarse en entornos muy tranquilos con detectores muy limpios y sin

radiactividad salvo la del núcleo que tratas de estudiar”.

Los físicos aún están evaluando su comprensión de las esquivas partículas.

“Ha habido tantas sorpresas procedentes

de la física de neutrinos”, apunta Reina Maruyama, profesor de la

Universidad de Yale asociado al experimento CUORE sobre desintegración

doble beta sin neutrinos. “Creo que es realmente apasionante pensar en

lo que no sabemos”.

Fuente: http://www.cienciakanija.com/